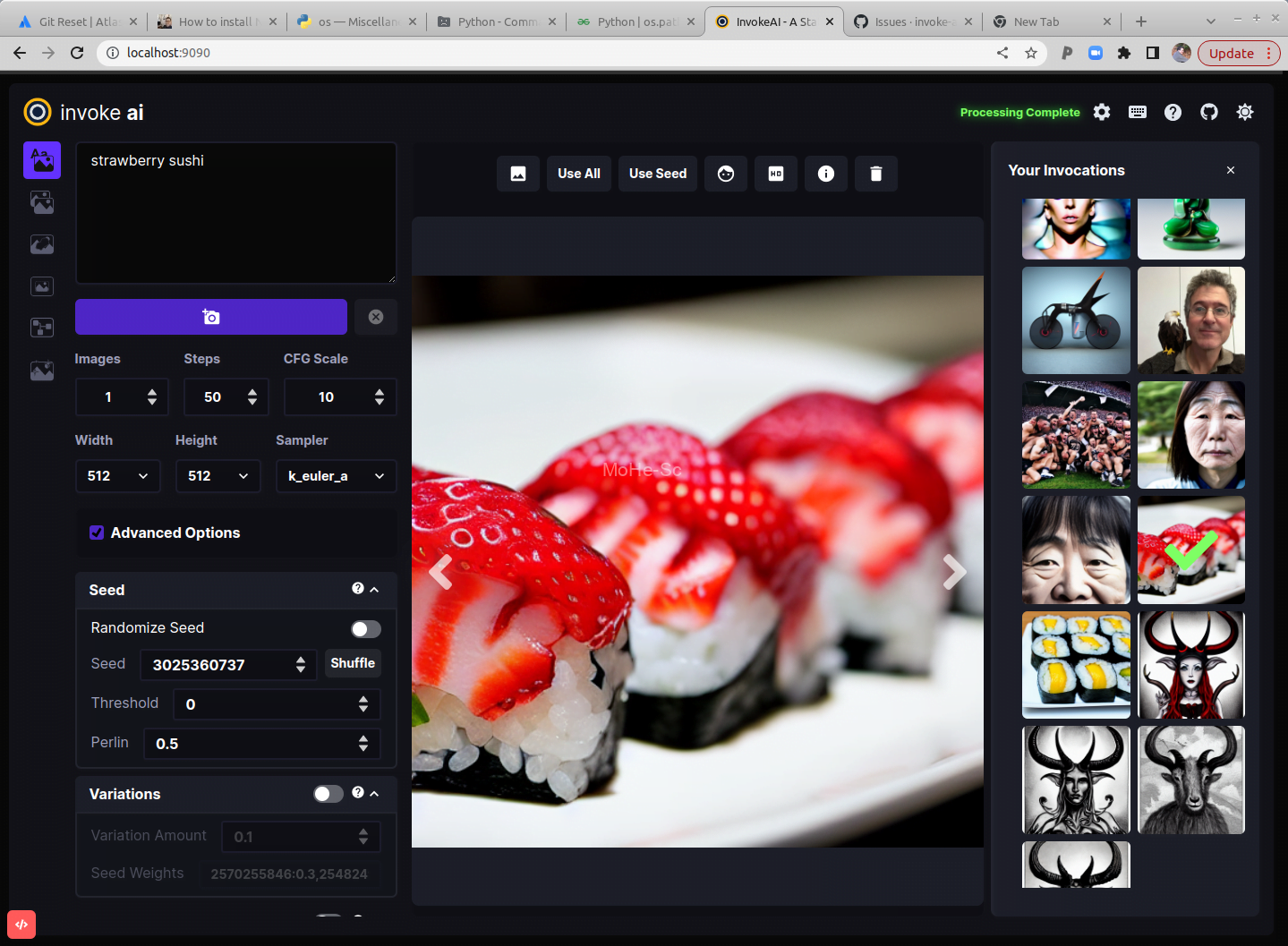

如果您正在寻找一个专门为WINDOWS设计的Stable Diffusion WebUI解决方案,那么Invoke AI将会非常适合您的需求。

现在,Invoke AI的独立安装包可轻松安装,无需担心环境配置问题,稳定运行,同时具有强大的Stable Diffusion WebUI,使您能够轻松管理和使用您的AI模型。

对于大部分观众来说,对Stable Diffusion WebUI主要注重的功能,是在于作图。Invoke AI完全可以满足这方面的需求,相比另一款WEBUI — AUTOMATIC1111, 避免了繁琐的安装和配置过程。

Invoke AI WINDOWS一键安装包具有以下特点:

稳定运行

Invoke AI采用了最新的Stable Diffusion WebUI技术,让整个系统更加稳定可靠。即使您不是专业人士,也能够轻松使用。

环境无需配置

作为一款独立安装包,Invoke AI无需配置任何环境,您只需要简单地下载安装包,进行安装即可。这对于没有编程经验的用户来说,无疑是一大福音。

操作简单

Invoke AI拥有简洁的界面和易于理解的操作方法,让您轻松掌握它的使用技巧。无论您是专业人士还是初学者,都可以在短时间内上手使用。

支持多语言

内置支持中文界面,无需额外安装插件。

硬件要求

您将需要以下其中一项:

基于 NVIDIA 的图形卡,具有 4 GB 或更多 VRAM 内存。

具有 4 GB 或更多 VRAM 内存的基于 AMD 的显卡(仅限 Linux)

带有 M1 芯片的 Apple 电脑。

我们不推荐以下视频卡,因为它们在半精度模式下运行时存在问题,并且 VRAM 不足以在全精度模式下渲染 512×512 图像:

NVIDIA 10xx 系列显卡,例如 1080ti

GTX 1650 系列显卡

GTX 1660 系列显卡

内存和磁盘

至少 12 GB 主内存 RAM。

至少 18 GB 的可用磁盘空间用于机器学习模型、Python 及其所有依赖项。

安装

自动安装

自动安装程序是一个 Python 脚本,可自动执行在运行最新版本的 Linux、MacOS 或 Windows 的库存计算机上安装和运行 InvokeAI 所需的步骤。它将为您提供一个运行稳定版本的 InvokeAI 的版本,并可选择稍后升级到实验版本。

要求

- 硬件要求:确保您的系统满足硬件要求并安装了适当的 GPU 驱动程序。对于安装了 NVIDIA 卡的系统,您需要安装 CUDA 驱动程序,而基于 AMD 的卡需要安装 ROCm 驱动程序。在大多数情况下,如果您已经将系统用于游戏或其他图形密集型任务,则已经安装了适当的驱动程序。如果不确定,请查看GPU 驱动程序指南

- 软件要求:检查您的系统是否安装了最新的 Python。为此,打开一个命令行窗口(在 Linux 和 Macintosh 上为“Terminal”,在 Windows 上为“Command”或“Powershell”)并键入python –version. 如果安装了 Python,它会打印出版本号。如果是 version3.9.或3.10.,则满足要求。我们不建议使用 Python 3.11 或更高版本,因为并非 InvokeAI 依赖的所有库都适用于此版本。

- 下载安装程序:InvokeAI 安装程序以 ZIP 文件的形式分发。转到 最新版本,并查找名为的文件:

调用AI-installer-v2.XXzip

其中“2.XX”是最新发布的版本。该文件位于发布页面的最底部,在Assets下。

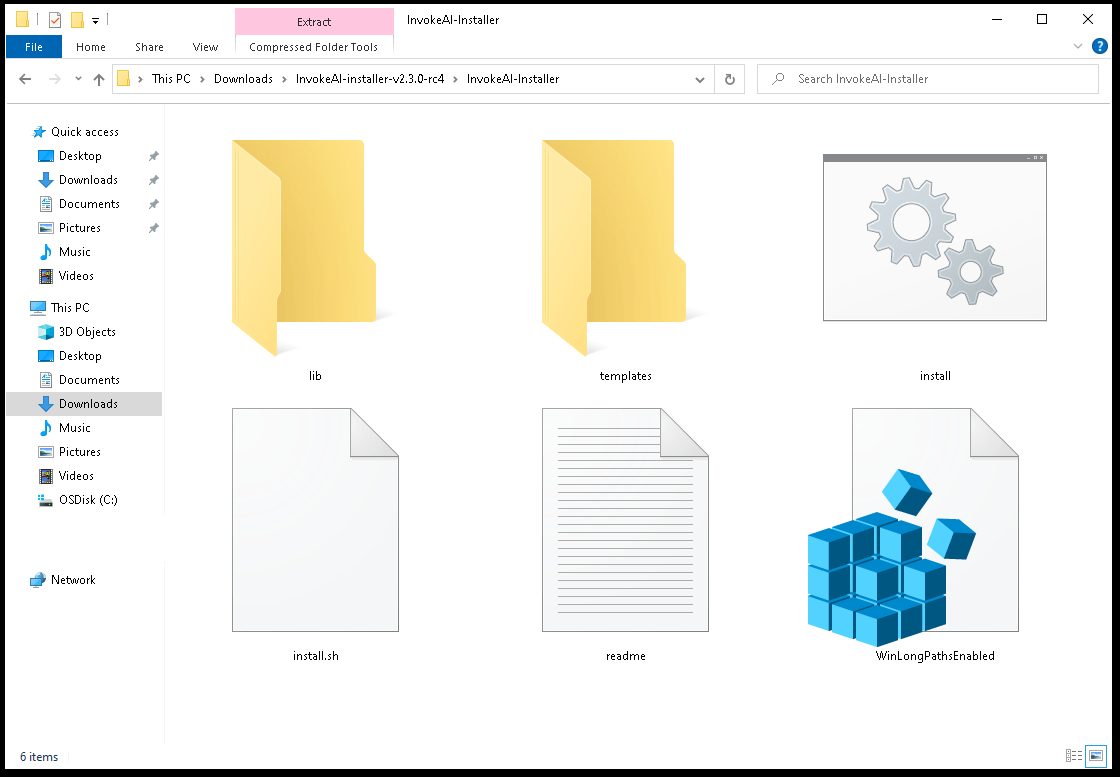

- 解压安装程序:将 zip 文件解压到一个方便的目录中。这将创建一个名为“InvokeAI-Installer”的新目录。解压后,目录如下所示:

- 从桌面启动安装程序脚本:如果您使用的是桌面 GUI,请双击适合您平台的安装程序文件。它将

install.bat在 Windows 系统以及install.shLinux 和 Macintosh 系统上命名。请注意,您系统的文件浏览器可能会禁止显示文件扩展名。在 Windows 系统上,如果您收到“Untrusted Publisher”警告。单击“更多信息”,然后选择“仍然运行”。你信任我们,对吧? - [替代] 从命令行启动安装程序脚本:或者,从命令行运行 shell 脚本或 .bat 文件:

C:\Documents\Linco> cd InvokeAI-InstallerC:\Documents\Linco\invokeAI> .\install.batC:\Documents\Linco> cd InvokeAI-Installer C:\Documents\Linco\invokeAI> .\install.batC:\Documents\Linco> cd InvokeAI-Installer C:\Documents\Linco\invokeAI> .\install.bat

- Select the location to install InvokeAI : 该脚本将要求您选择安装 InvokeAI 的位置。选择至少有 18G 可用空间的目录进行完整安装。InvokeAI 及其所有支持文件将安装到

invokeai位于您指定位置的名为 located 的新目录中。

- 默认情况下是将

invokeai目录安装在您的主目录中,通常C:\Users\YourName\invokeai在 Windows 系统、/home/YourName/invokeaiLinux 系统和/Users/YourName/invokeaiMacintoshes 上,其中“YourName”是您的登录名。

-如果您之前安装过InvokeAI,系统会要求您确认是否要重新安装到该目录。您可以选择重新安装,在这种情况下您的版本将升级,或者选择不同的目录。

- 该脚本使用制表符自动完成来建议目录路径完成。键入部分路径(例如“C:\Users”)并Tab重复按以提示完成。

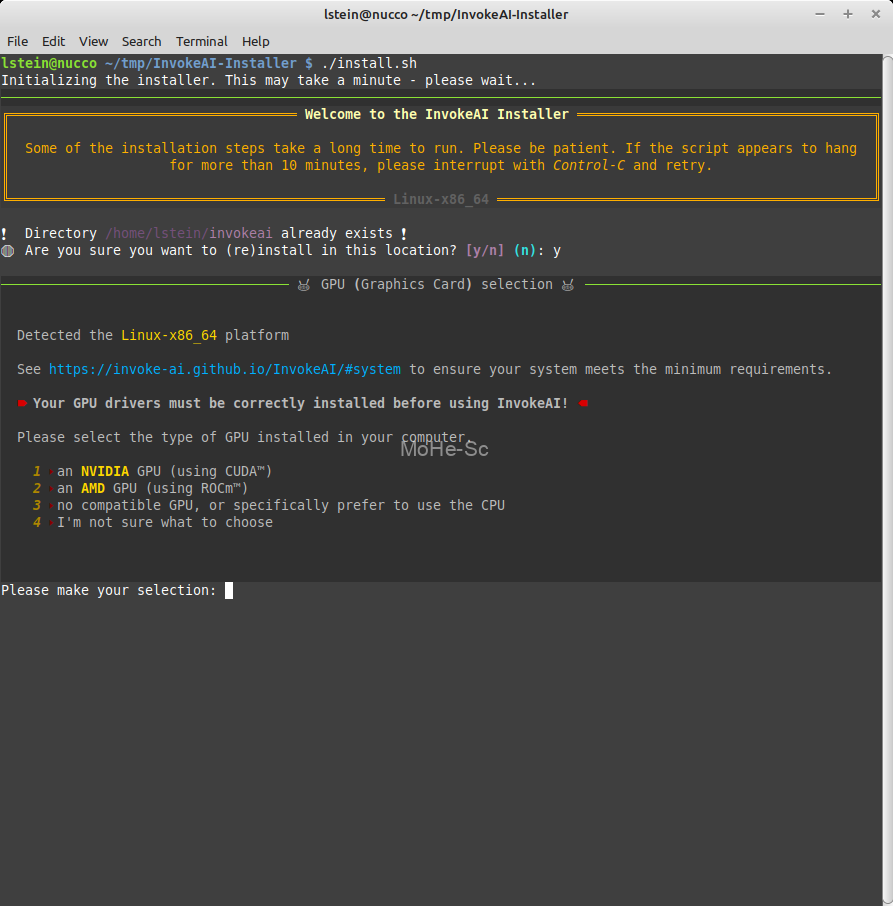

- 选择您的 GPU:安装程序将自动检测您的平台,并要求您确认您的显卡的 GPU 类型。在 Linux 系统上,您可以选择 CUDA(NVidia 卡)、ROCm(AMD 卡)或 CPU(无图形加速)。在 Windows 上,您可以选择 CUDA 还是 CPU,而在 Mac 上,您只能选择 CPU。当您在 M1 或 M2 Macintoshes 上选择 CPU 时,您将获得基于 MPS 的图形加速,而无需安装额外的驱动程序。如果您不确定您使用的是什么 GPU,您可以让安装人员猜测。

- 看着它走!: 坐下来让安装脚本工作。它将安装 InvokeAI 和应用程序本身所需的第三方库。

- 请注意,某些库的下载和安装步骤需要很长时间。特别是,

pytorch包很大,经常出现“卡在”99.9% 的情况。耐心等待,安装步骤最终会恢复。但是,有时库安装确实会卡住。如果您已经等待了十多分钟而没有任何反应,您可以使用 ^C 中断脚本。您可以重新启动它,它会从中断的地方继续。

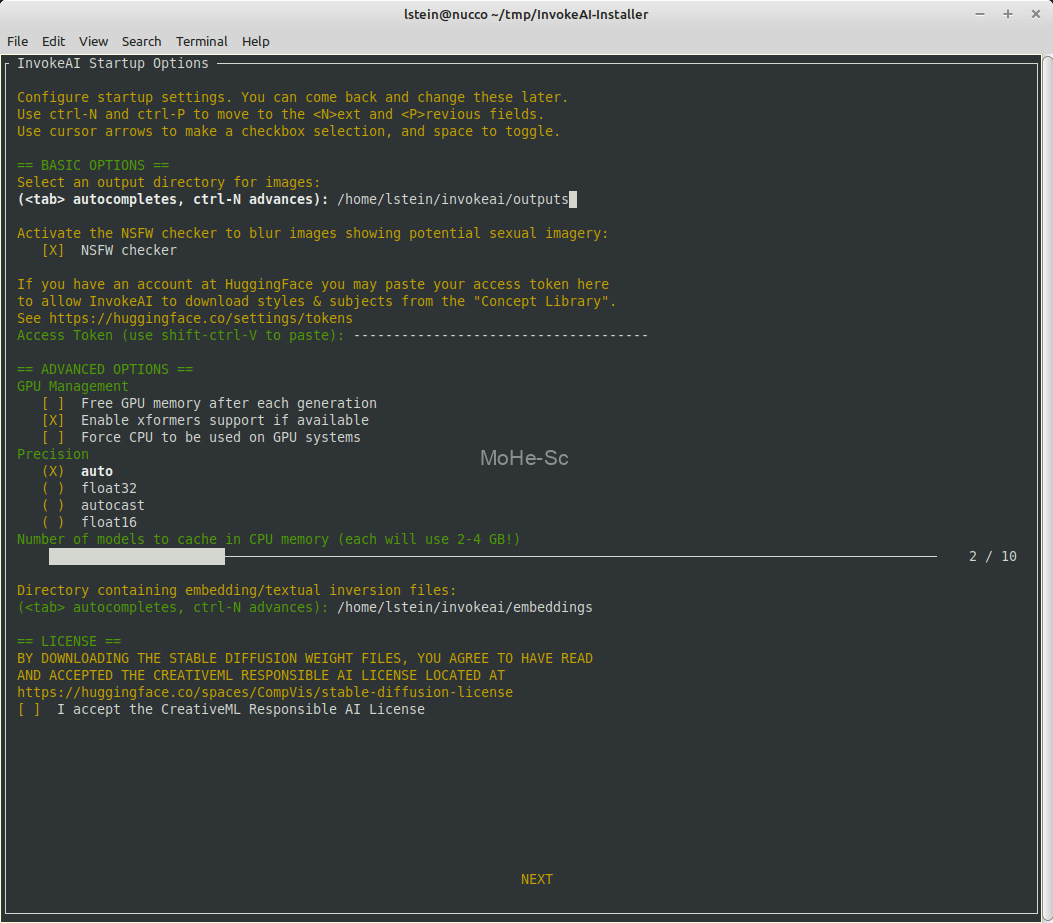

Post-install Configuration:安装完成后,安装程序将启动配置表单,它将引导您完成调整 InvokeAI 的一些启动设置的首次过程。要在这个表单中移动,请使用 ctrl-N 表示 <N>ext,ctrl-P 表示 <P>revious,或者使用 <tab> 和 shift-<tab> 来回移动。进入多复选框字段后,使用向上和向下光标键选择所需的项目,然后使用 <space> 将其打开和关闭。在目录字段中,按 <tab> 将提供自动完成选项。

- 通常默认设置很好,您可以随时返回此屏幕来调整您的系统。以下是您可以调整的选项:

- 图像的输出目录 这是 InvokeAI 将存储其所有生成图像的目录的路径。

- NSFW 检查器 如果选中,InvokeAI 将测试图像中是否存在潜在的色情内容,如果发现则将其模糊处理。请注意,NSFW 检查器在大多数图像模型使用的 2-3 GB VRAM 之上额外消耗 0.6 GB VRAM。如果您的 VRAM GPU (4-6 GB) 较低,则可以通过禁用检查器来减少内存不足错误。

- HuggingFace 访问令牌 InvokeAI 能够按需从 HuggingFace 概念库下载嵌入式样式和主题。但是,某些概念库文件受密码保护。为了让下载更顺畅,您可以在 huggingface.co 上建立一个帐户,获取一个访问令牌,并将其粘贴到该字段中。请注意,您使用 ctrl-shift-V 粘贴到此屏幕

- 每一代后释放 GPU 内存 这对低内存机器很有用,有助于最大限度地减少 InvokeAI 使用的 GPU VRAM 量。

- 启用 xformers 支持(如果可用) 如果 xformers 库已成功安装,这将激活它以减少内存消耗并显着提高渲染速度。请注意,即使使用相同的种子和其他设置,xformers 也会生成略有不同的图像的副作用。

- 强制在 GPU 系统上使用 CPU 这将使用(慢速)CPU 而不是加速的 GPU。这可用于在没有兼容 GPU 的系统上生成图像。

- 精度 这控制是否使用 float32 或 float16 算法。float16 使用较少的内存,但也不太准确。通常会自动选择正确的算法(“自动”),但您可能必须使用 float32 才能在某些系统和显卡上获取图像。“autocast”选项已弃用,除非团队成员要求,否则不应使用。

- 在 CPU 内存中缓存的模型数量 这允许您将模型保留在内存中并在它们之间快速切换,而不是每次都从磁盘加载它们。此滑块控制一次加载多少个模型。每个模型将使用 2-4 GB 的 RAM,因此请谨慎使用

- 包含嵌入/文本反转文件的目录 这是您可以放置自定义嵌入文件(.pt 或 .bin)的目录。在启动期间,将扫描此目录,InvokeAI 将打印出可用于触发嵌入的文本术语。

- 在屏幕底部,您将看到一个复选框,用于接受 CreativeML Responsible AI License。您需要接受许可才能从下一个屏幕下载 Stable Diffusion 模型。

- 您可以根据需要多次返回启动选项表单。从

invoke.sh或invoke.bat启动器中,选择选项 (6) 以重新启动此脚本。在命令行上,它被命名为invokeai-configure.

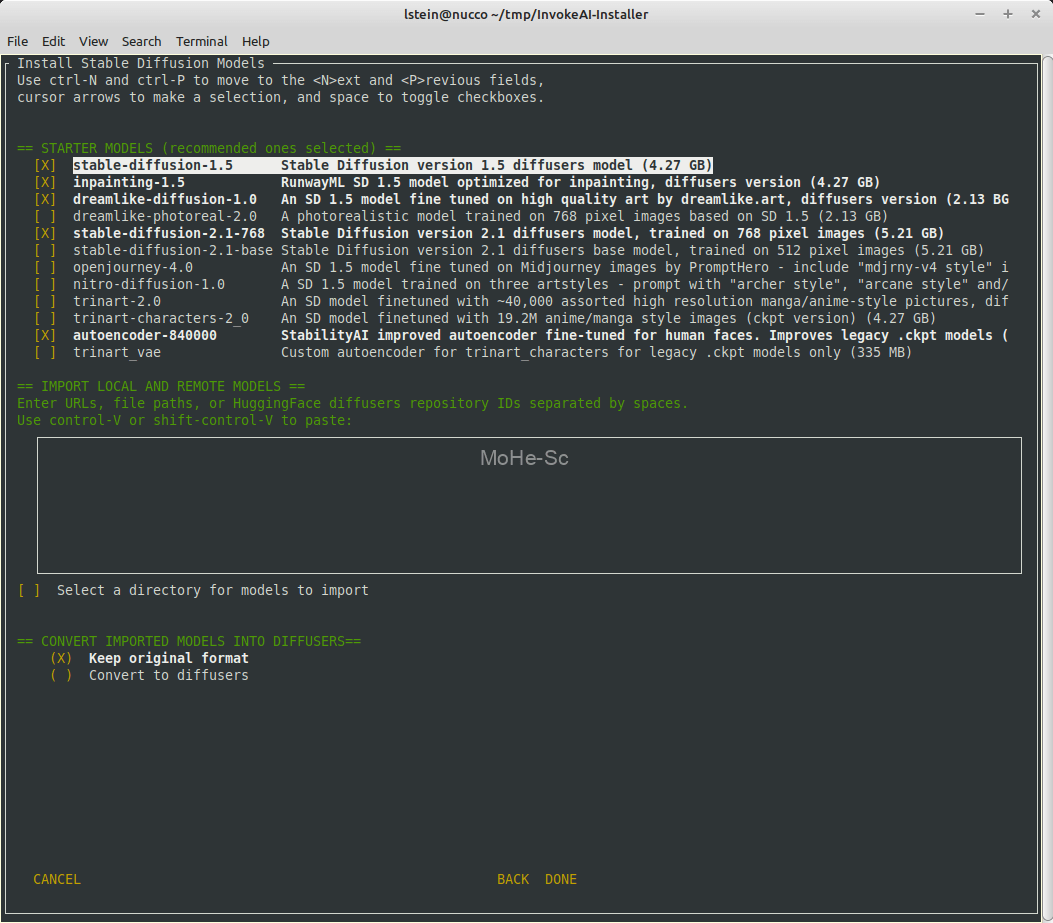

下载模型:按下[NEXT]屏幕后,您将被带到另一个屏幕,提示您下载一系列入门模型。我们推荐的那些是为您预先选择的,但我们鼓励您使用复选框进行选择。您可能希望下载autoencoder-840000使用旧版 Stability VAE 训练的模型。

在预选的入门模型列表下方是一个大文本字段,您可以使用它来指定要导入的一系列模型。您可以指定多种格式的模型,每种格式以空格或换行符分隔。接受的格式是:

- .ckpt 或 .safetensors 文件的路径。在大多数系统上,您可以将文件从文件浏览器拖到文本字段以自动粘贴路径。请务必删除多余的引号和其他随附的内容。

.ckpt包含和文件组合的目录的路径.safetensors。该目录将从上到下扫描(包括子文件夹),并且将扫描任何可以导入的文件。- 指向

.ckpt或.safetensors文件的 URL。您可以直接从网页剪切和粘贴,或者直接从网页或导航栏中拖动链接。(您也可以使用 ctrl-shift-V 粘贴到该字段)文件将被下载并安装。 - 模型的 HuggingFace 存储库 ID (repo_id)

diffusers。这些 ID 的格式为author_name/model_name,如andite/anything-v4.0 - 包含模型的本地目录的路径

diffusers。这些目录的文件总是位于model_index.json其顶层。

选择要导入模型的目录您可以选择一个本地目录以在启动时自动导入。如果您选择此选项,每次 InvokeAI 启动时都会扫描您选择的目录以查找新的 .ckpt/.safetensors 文件,并且任何新文件都将自动导入并可供您使用。

将导入的模型转换为扩散器导入遗留检查点文件时,您可以选择不加修改地使用它们(默认)或将它们转换为diffusers模型。后者加载速度更快,渲染性能略好,但并非所有检查点文件都可以转换。请注意,Stable Diffusion 版本 2.X 文件仅在diffusers格式上受支持,并且无论如何都会被转换。

您可以多次返回模型安装表单。从invoke.sh或invoke.bat启动器中,选择选项 (5) 以重新启动此脚本。在命令行上,它被命名为invokeai-model-install.

第一次运行 InvokeAI:脚本现在将退出,您将准备好生成一些图像。查找invokeai安装在您在安装会话开始时选择的位置的目录。查找名为invoke.sh (Linux/Mac) 或invoke.bat(Windows) 的 shell 脚本。通过双击脚本或在命令行中键入其名称来启动脚本:

C:\Documents\Linco> cd invokeaiC:\Documents\Linco\invokeAI> invoke.batC:\Documents\Linco> cd invokeai C:\Documents\Linco\invokeAI> invoke.batC:\Documents\Linco> cd invokeai C:\Documents\Linco\invokeAI> invoke.bat

invoke.bat( )脚本invoke.sh将为您提供启动 (1) 命令行界面、(2) Web GUI、(3) 文本反转训练和 (4) 模型合并的选择。- 默认情况下,脚本将启动 Web 界面。执行此操作时,您会看到一系列启动消息,并以将浏览器指向 http://localhost:9090 的说明结尾。单击此链接打开浏览器并开始探索 InvokeAI 的功能。

InvokeAI 选项:您可以使用几个自定义其行为的不同命令行参数来启动 InvokeAI。例如,您可以更改图像输出目录的位置,或选择您喜欢的采样器。有关选项的完整列表,请参阅 命令行界面。

- 要设置每次启动 InvokeAI 时都会生效的默认值,请使用文本编辑器(例如记事本)退出文件

invokeai\invokeai.init。它包含各种示例,您可以按照这些示例添加和修改启动选项。 - 启动器脚本还为您提供了一个标有“打开开发人员控制台”的选项。如果选择此选项,您将进入命令行界面,您可以在其中直接运行 python 命令、访问开发人员工具以及使用自定义选项启动 InvokeAI。

手动安装

建议有经验的用户和开发人员使用此方法

Docker安装

对于熟悉运行 Docker 容器的人,建议使用此方法

![百度网盘直链解析彻底解除百度云限速限制[利用IDM工具在线解析网页版]-MOHE素材库-设计行业的乐园,各类素材的矿山!](http://mohe-sc.com/wp-content/uploads/2021/07/baiduwangpan-400x273.png)

请登录后查看评论内容