Meta Llama 2 简介:

市值近8000亿美元的科技巨头Meta(原Facebook,NASDAQ: META)发布最新AI 大语言模型Llama 2系列,包含70亿、130亿和700亿三种参数版本,模型信息和起始代码全部开源,并支持免费可商用,还包含针对会话聊天场景微调的Llama 2-CHAT模型版本。

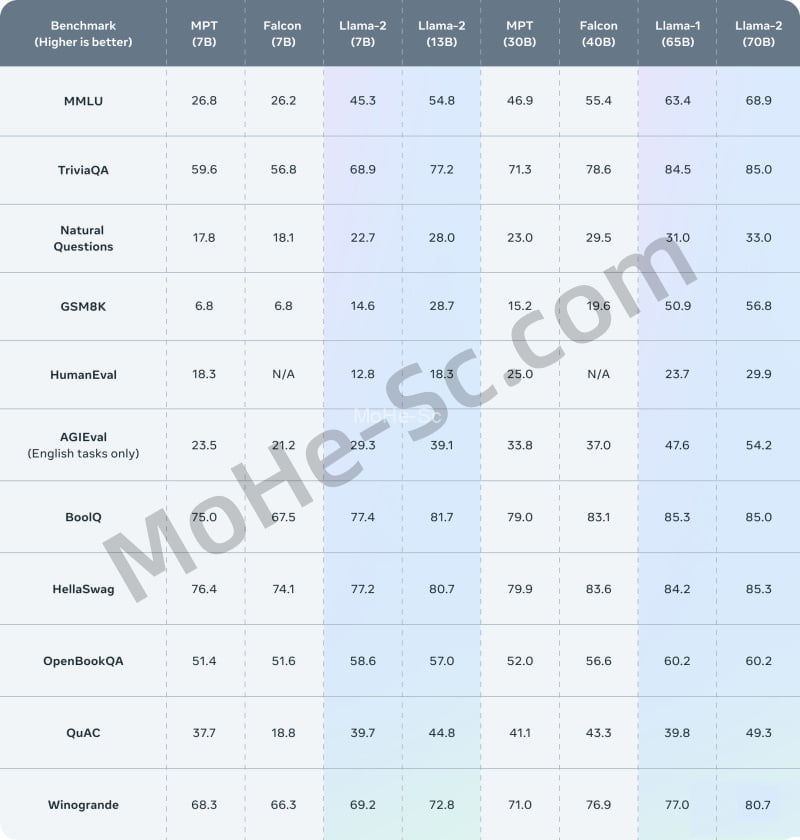

相较于今年2月发布的Llama 1,最新Llama 2训练所用的token翻了一倍至2万亿。Meta表示,在包括推理、编码、精通性和知识测试等多个外部基准评分测评中,Llama 2表现优于所有开源的Chat模型。

同时,Meta今晨还宣布与微软、高通公司展开合作,Llama 2将部署在微软云服务Azure上,同时Llama 2将能在高通芯片上运行,打破市场上英伟达、AMD处理器对 AI 算力市场的垄断。

“微软是我们Llama 2的首选合作伙伴,并扩大我们在生成式人工智能(AIGC)方面的努力。”Meta认为,开放的方法对于当今 AI 模型开发是正确的,特别是那些在技术快速发展的大模型。公司还在论文中称,根据Meta对有用性和安全性的人工评估,Llama 2可能是封闭模型的合适替代产品。

LLaMA(Lager Language Model From Meta),这是一个从7B到65B参数的基础语言模型的集合。它在数万亿的文本tokens上训练的模型,并表明在不求助于专有和不可访问的数据集,而仅使用公开的数据集来训练最先进的模型是可能的。特别是,LLaMA-13B在大多数基准测试上优于GPT-3(175B),而且LLaMA-65B与最好的型号钦奇利亚-70B和PaLM-540B具有竞争力。

LLaMA模型的目标是用一个较小的模型在更大数据集上进行更长时间的训练,以此来达到相同或更高精度的模型。因为小模型的推理成本更低,所以其部署时所需要的资源条件也更加便宜,这使得不具有高硬件资源的个人或机构也能研究LLMs。

该模型目前支持70亿、130亿、700亿等多个参数规模版本。相较Llama 1,Llama 2经过2万亿个tokens训练,其对上下文训练的长度是Llama 1的两倍,达到4096。Llama-2-chat模型还接受了超过100万个人工标注训练。由于其强大的参数规模以及性能表现,不少人称之为“GPT-4最强平替”,也是大模型之战中AI平权的又一例证。

此外,Meta和微软高调宣布将在生成式AI领域联手,微软将成为Llama 2的首选合作伙伴。微软Azure客户将能够在Azure上轻松安全地微调和部署Llama 2模型,快速构建适用于自身业务的专用大模型。

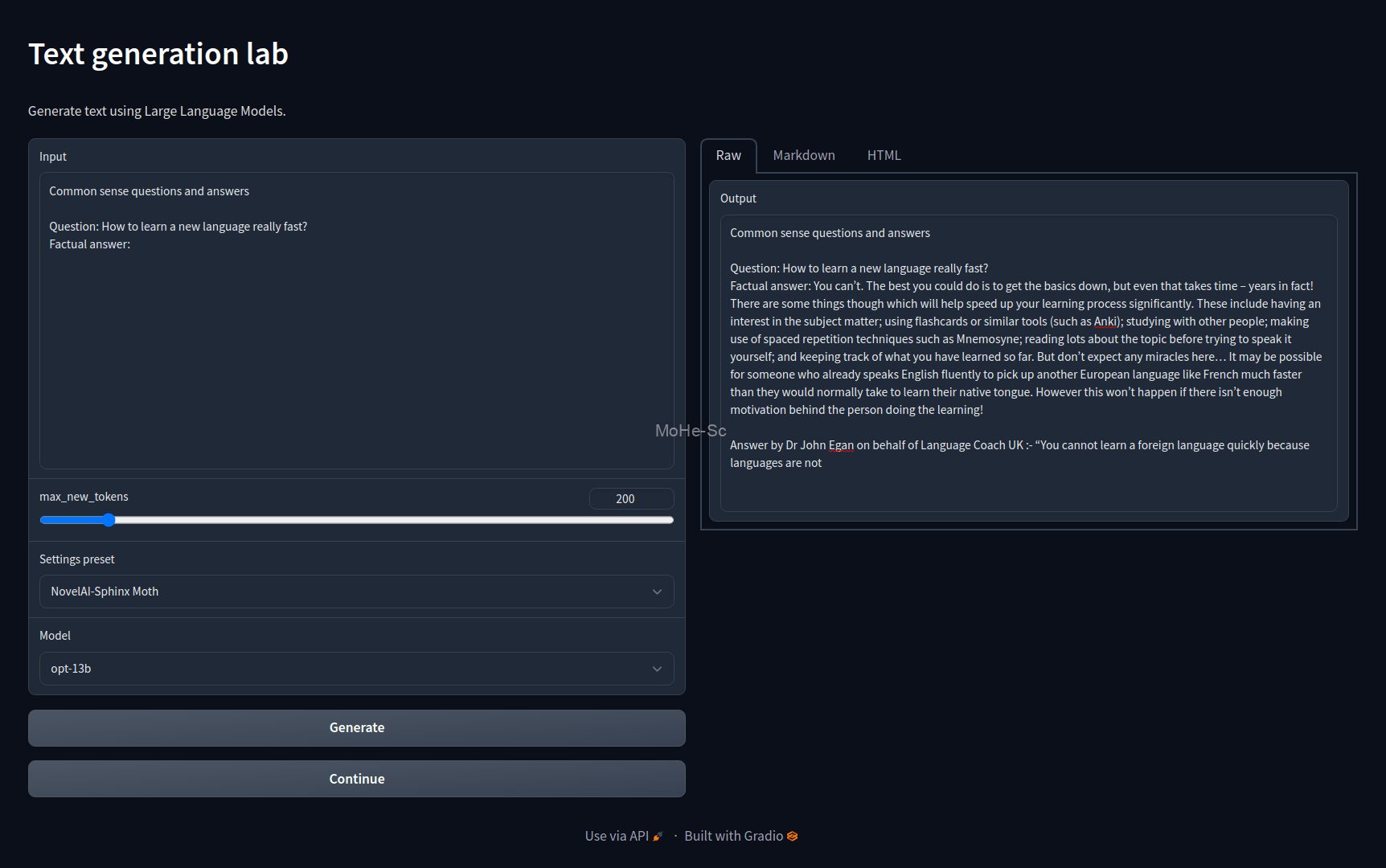

一键安装

只需下载上面的 zip 文件,将其解压,然后双击“开始”即可。Web UI 及其所有依赖项将安装在同一文件夹中。

- 源代码在这里: https: //github.com/oobabooga/one-click-installers

- 无需以管理员身份运行安装程序。

- AMD 不适用于 Windows。

使用 Conda 手动安装

如果您有一些命令行经验,建议您使用。

0.安装Conda

在 Linux 或 WSL 上,可以使用以下两个命令自动安装:

curl -sL "https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh" > "Miniconda3.sh"

bash Miniconda3.sh

来源: https: //educe-ubc.github.io/conda.html

1.新建conda环境

conda create -n textgen python=3.10.9

conda activate textgen

2.安装Pytorch

| 系统 | 图形处理器 | 命令 |

|---|---|---|

| Linux/WSL | 英伟达 | pip3 install torch torchvision torchaudio |

| Linux | AMD | pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/rocm5.4.2 |

| MacOS + MPS(未经测试) | 任何 | pip3 install torch torchvision torchaudio |

| 视窗 | 英伟达 | pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu117 |

最新的命令可以在这里找到: https: //pytorch.org/get-started/locally/。

2.1 特别说明

- MacOS 用户:#393

- AMD 用户:https://rentry.org/eq3hg

3. 安装网页用户界面

git clone https://github.com/oobabooga/text-generation-webui

cd text-generation-webui

pip install -r requirements.txt

位和字节

位和字节 >= 0.39 可能无法在较旧的 NVIDIA GPU 上运行。在这种情况下,要使用--load-in-8bit,您可能必须像这样降级:

- Linux:

pip install bitsandbytes==0.38.1 - 视窗:

pip install https://github.com/jllllll/bitsandbytes-windows-webui/raw/main/bitsandbytes-0.38.1-py3-none-any.whl

替代方案:Docker

ln -s docker/{Dockerfile,docker-compose.yml,.dockerignore} .

cp docker/.env.example .env

# Edit .env and set TORCH_CUDA_ARCH_LIST based on your GPU model

docker compose up --build

更新要求

时不时地,发生requirements.txt变化。要更新,请使用以下命令:

conda activate textgen

cd text-generation-webui

pip install -r requirements.txt --upgrade

![百度网盘直链解析彻底解除百度云限速限制[利用IDM工具在线解析网页版]-MOHE素材库-设计行业的乐园,各类素材的矿山!](http://mohe-sc.com/wp-content/uploads/2021/07/baiduwangpan-400x273.png)

![关于本站启用[注册邀请码]的说明-MOHE素材库-设计行业的乐园,各类素材的矿山!](https://www.mohe-sc.com/wp-content/uploads/2022/10/2023_09xI0Dxg_-800x448.png)

请登录后查看评论内容